# 读取文件数据写入Kafka

本示例主要演示从data.json文件中读取数据,写入Kafka json主题中。

主要步骤如下:

# 准备数据

1、在Kafka中创建主题json

2、在/home/dws/infile下创建文件data.json,配置权限与seatunnel权限相同,写入数据

data.json内容:

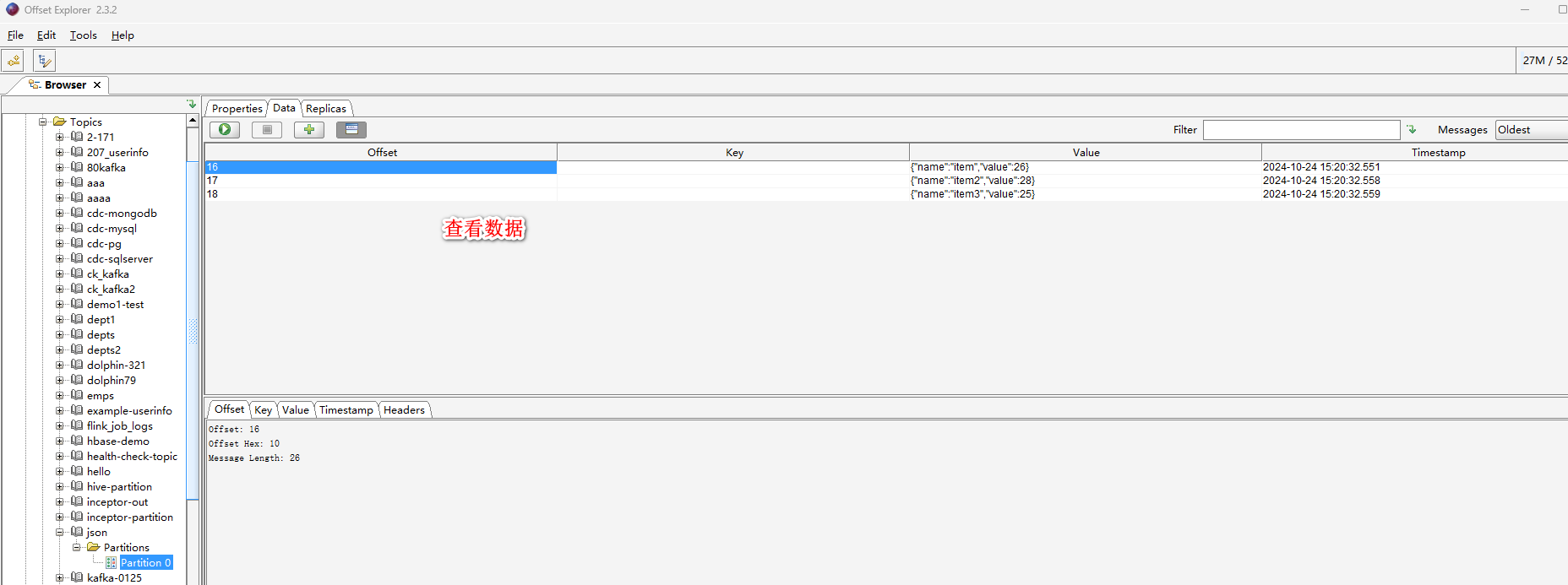

{"name":"item","value":26}

{"name":"item2","value":28}

{"name":"item3","value":25}

# 新建同步作业

点击数据同步上的【...】,选择弹出菜单【新建数据同步作业】,作业名称为:localfile-json。

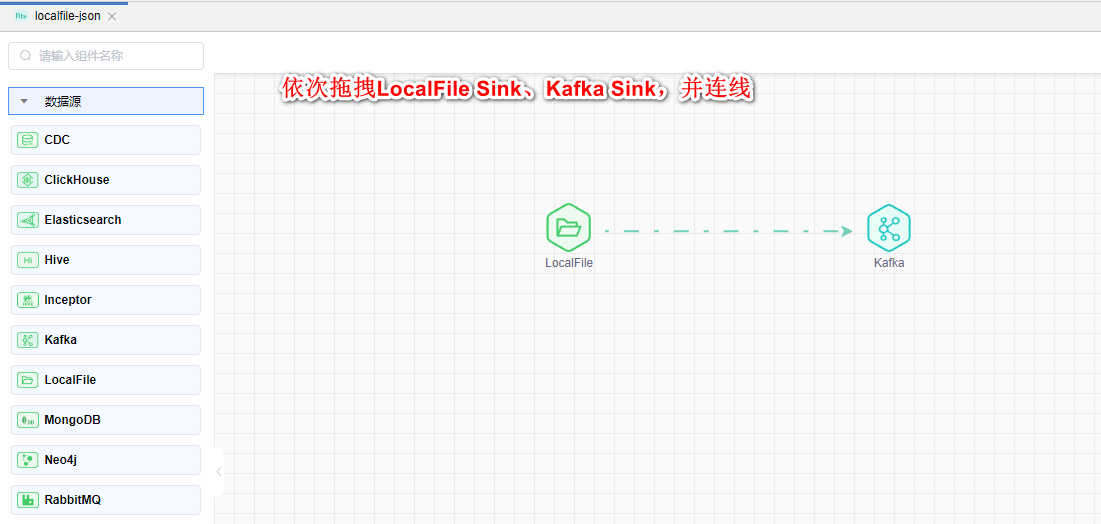

# 拖拽图元

依次拖拽数据源中的LocalFile Source组件和目标中的Kafka Sink组件,依次连线。如下图所示:

# 配置组件属性

1、双击"LocalFile Source"组件,根据下图所示步骤依次配置。

2、双击"Kafka Sink"组件,根据下图所示步骤依次配置。

3、Ctrl+S保存该模型。

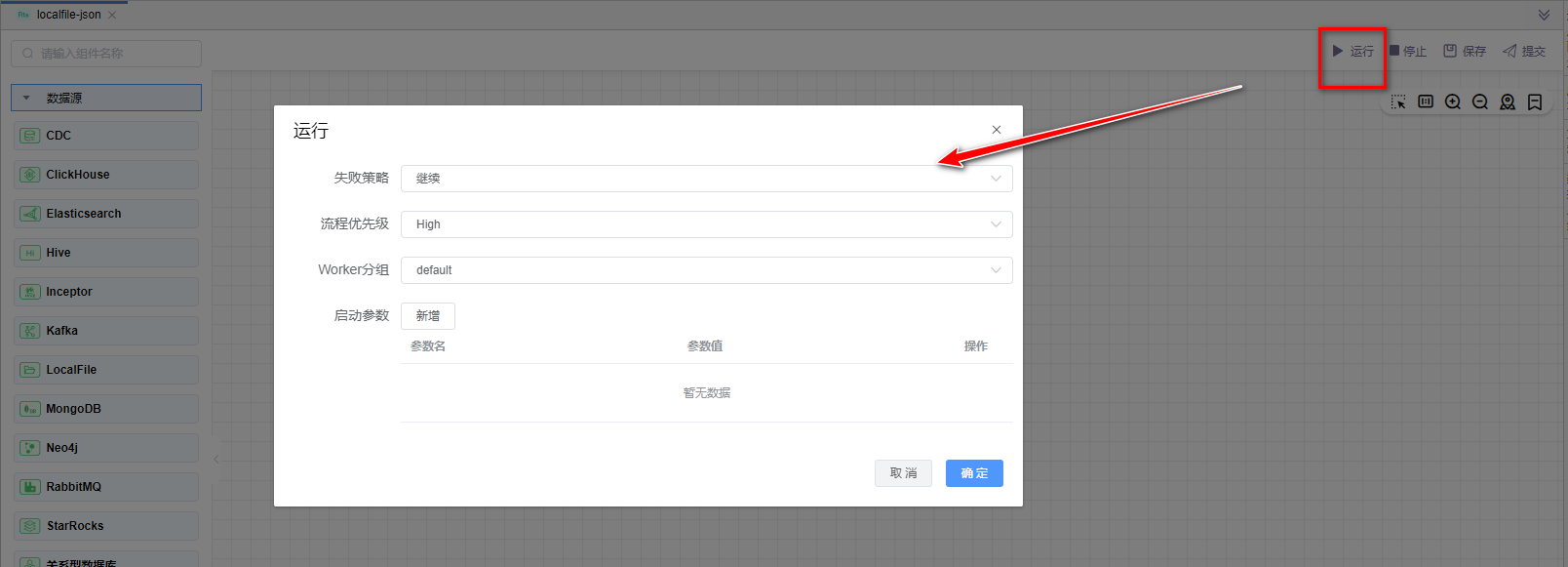

# 运行

点击【运行】按钮,可以运行已经开发完毕的场景,在日志栏可以看运行日志及运行结果。

# 查看数据

使用Kafka可视化工具查看数据(Kafka可视化工具可自行下载)。

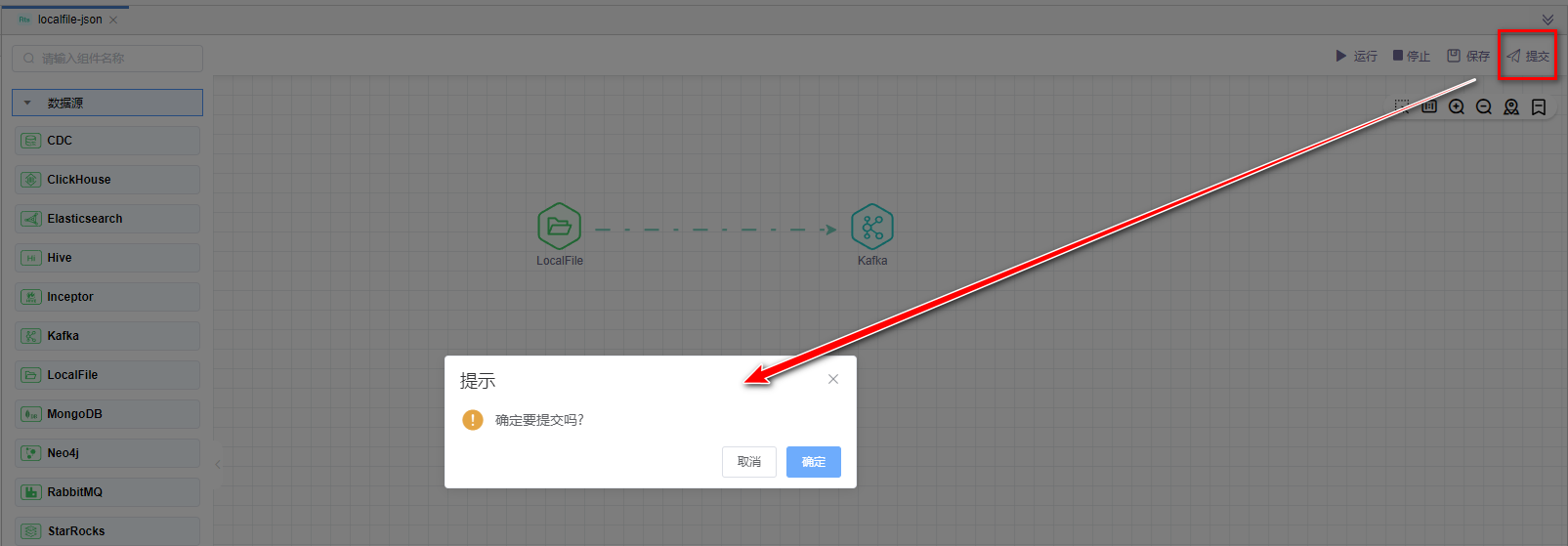

# 提交版本

当草稿运行正常后,点击【提交】按钮可以将该版本提交到作业调度,每次修改提交都会生成新的版本,可以看到提交的历史版本,并可以随意切换版本。

提交后的版本,可以在作业调度中进行"定时"调度配置。